Artykuł naszych naukowców pt. „OpenFact at CheckThat! 2024: Combining Multiple Attack Methods for Effective Adversarial Text Generation” został opublikowany w otwartym dostępie. W ramach pracy zostało opisane podejście, które zajęło pierwsze miejsce w międzynarodowym konkursie w obszarze wiarygodności informacji.

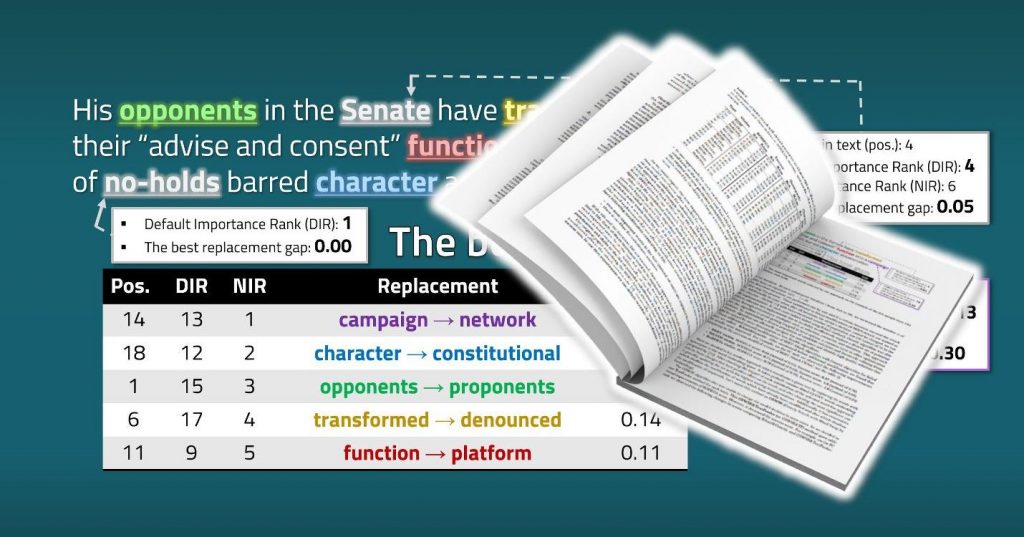

Konkurs był organizowany w ramach międzynarodowej konferencji CLEF 2024 (Conference and Labs of the Evaluation Forum). Celem konkursu była weryfikacja odporności popularnych podejść do klasyfikacji tekstu stosowanych do problemów oceny wiarygodności. Zadaniem uczestników konkursu było stworzenie przykładów kontradyktoryjnych (antagonistycznych lub zainfekowanych, z ang. „adversarial examples”) – czyli zmodyfikowanie tekstów w taki sposób, aby algorytmy klasyfikacyjne zmieniły swoją decyzję na przeciwną, ale bez zmiany znaczenia tekstu. Wyzwanie polegało na tym, że teksty musiały być zmodyfikowane w taki sposób, żeby nie tylko zmienić decyzję każdego z trzech różnych klasyfikatorów (opartych na modelach BERT, BiLSTM i RoBERTa) na każdym z ponad 2000 przykładów tekstowych, ale również zadbać o minimalną liczbę zmian symboli (słów) w tekstach oraz maksymalne zachowanie ich znaczenia semantycznego. Poza tym, zadanie obejmowało teksty z 5 różnych obszarów problematycznych: ocena stronniczości wiadomości, wykrywanie propagandy, sprawdzanie faktów, wykrywanie plotek oraz dezinformacji związanej z COVID-19.

Opisane w artykule podejście może pomóc w doskonaleniu algorytmów uczenia maszynowego, które są używane w ramach różnych serwisów internetowych (np. media społecznościowe) do filtrowania treści, w szczególności w celu wykrywania tekstów wprowadzających w błąd, szkodliwych lub po prostu nielegalnych. Autorzy publikacji: dr Włodzimierz Lewoniewski, dr Piotr Stolarski, dr Milena Stróżyna, dr Elżbieta Lewańska, mgr inż. Aleksandra Wojewoda, mgr Ewelina Księżniak, mgr Marcin Sawiński.

Warto przypomnieć, że w tym roku naukowcy naszej Katedry zajęli pierwsze miejsce nie tylko w międzynarodowym konkursie w obszarze wiarygodności informacji, ale również w zakresie wczesnego wykrywania zagrożeń w Internecie. Poza tym, w roku 2023 zespół projektu OpenFact zajął pierwsze miejsce w konkursie „CLEF-2023 CheckThat! Lab” – najlepsza metoda pozwalająca wykrywać zdania w języku angielskim, które wymagają sprawdzenia ze względu na możliwość wprowadzania w błąd.

Katedra Informatyki Ekonomicznej realizuje obecnie projekt badawczy OpenFact, w ramach którego zajmuje się opracowaniem narzędzi do automatycznego wykrywania fake news w języku polskim. W lipcu 2024 roku wyniki projektu OpenFact drugi rok z rzędu zostały ocenione przez NCBiR jako najlepsze w Polsce. Zwycięstwo w prestiżowym konkursie „CheckThat!” potwierdza, że dokonania naszego zespołu są istotne w skali światowej oraz że metody opracowane przez zespół OpenFact osiągają równie wysoką skuteczność w innych językach.

Projekt OpenFact jest finansowany przez Narodowe Centrum Badań i Rozwoju w ramach programu INFOSTRATEG I „Zaawansowane technologie informacyjne, telekomunikacyjne i mechatroniczne”.